徐令予博客

考槃在涧,硕人之宽。独寐寤言,永矢弗谖。考槃在阿,硕人之薖。独寐寤歌,永矢弗过。考槃在陸,硕人之轴。独寐寤宿,永矢弗告。数据不支持九章取得了量子计算优势

作者:徐令予

本系列的前文介绍了 Torontonian 函数的身世,它是一个为了取得“量子优势”而特地制造出来的数学问题。经过如此煞费苦心的安排,在量子计算机vs超级计算机的对抗赛中,“九章”团队不仅成了竞赛项目和比赛规则的制定者,而且还充当了比赛的裁判员,哨音过后,宣布他们的光学实验装置比超级计算机快了100万亿倍(10^14),让世人着实吓了一大跳。

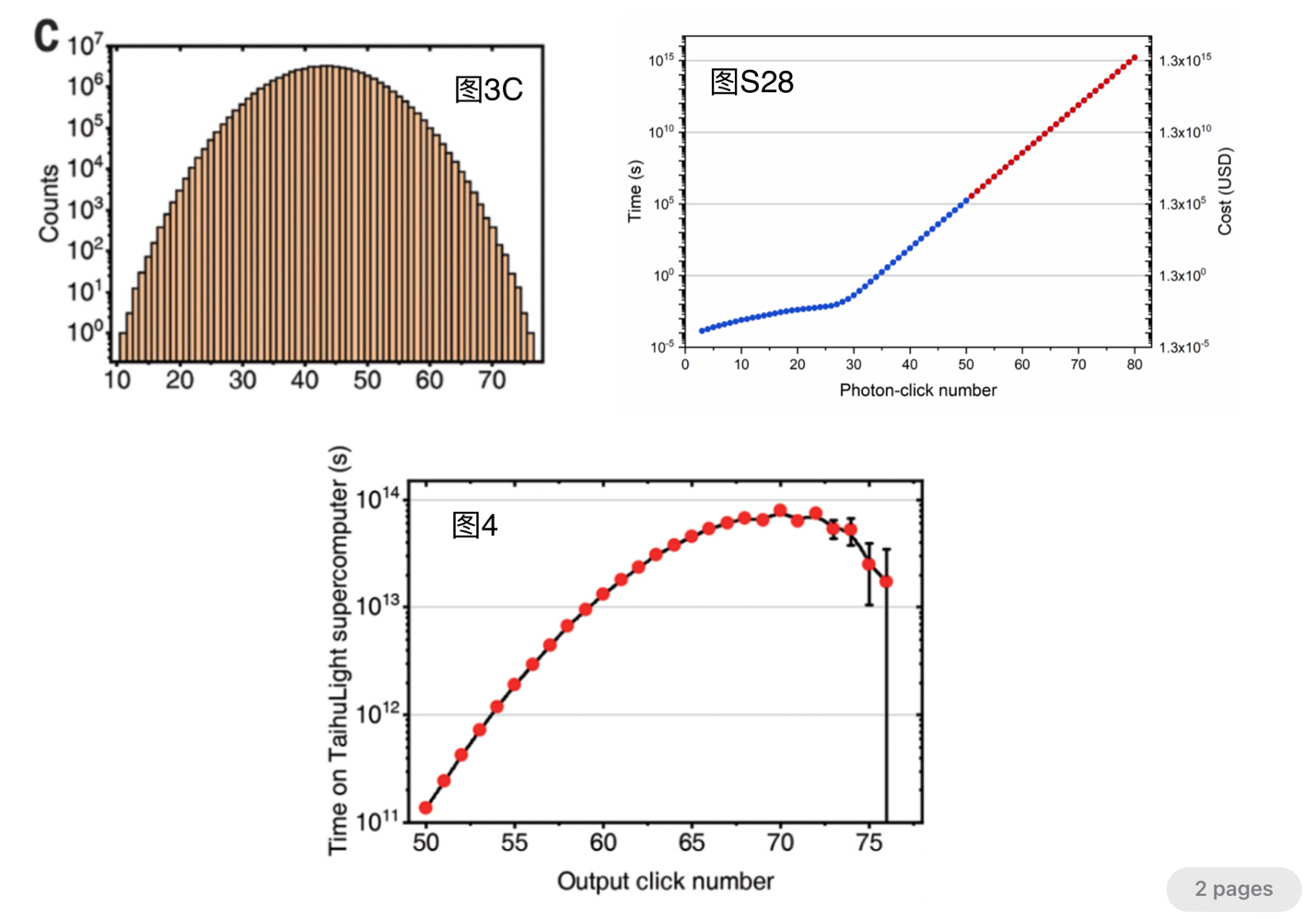

这个比赛结果究竟是如何算出来的呢?看完本文的解读,一定让你吓得跳三跳!所有的奥秘就在下面的三张图片中,它们分别是“九章”论文的图3C、图4、以及附件的图S28。

- 图3C中X轴是光子数,即每次釆样检测到有光子(有一个或者一个以上光子到达该出口)的出口的总数,Y轴的值则是在200秒的实验过程中检测到光子数为X的样本总数。例如,检测到光子数为50的样本数约为10^6次。

- 图S28给出了“太湖之光”超级计算机(简称超算,下同)通过对100维矩阵的Tor值计算,求得光子数为X的某种分布概率所需要的时间。例如,计算光子数为50的某种分布的概率,超算一共需要10^5秒(从数据输入到结果输出)。

- 图4是依据图3C和图S28数据计算得到的。对于图4曲线上每点的X值,把图3C中的相对应的Y值与图S28中相对应的Y值相乘就是图4中的Y值。例如,当光子数为50,超算需要的总时间是10^6次乘上10^5秒,约等于10^11秒。

最后把图4中超算对每种光子数计算时间的总和加起来(相当于求出图4曲线以下的总面积),约为8x10^16秒,而“九章”只需200秒,两者相比得出10^14,“九章”比超算快一百万亿倍就是这样搗鼓出来的。

但是图4曲线的产生过程中犯了概念性错误。请注意,图S28的Y值是超算求得有X个光子组成的某种分布的概率所需的时间,而图3C的Y值是实验中光子数为X的釆样总数,它并不是光子数为X的不同的分布数。因为在得到的Y次采样中,可能有N个样本属于同一种分布,它们组成了某一种有效样本,把N除以实验的总釆样数就是该分布的概率,而它对应的就是Tor的一次计算,超算是完全不需要重复计算N次的。另外,在得到的Y次釆样中,有些分布的样本又太少,它们不具有任何统计意义应该予以弃除,所以对应这些采样超算完全不需要浪费任何时间的。

请注意,对于X个光子如果总采样数是Y,它并不代表有Y种有效的分布,因为有许多次采样得到的是同一种分布,这恰恰是构成有效样本所必须的;反之,如果这Y次采样得到的全是不重复的分布,那么这些分布由于没有足够的样本数,它们全是无效的。

光子数为X的所有采样中究竟能有多少有效的分布呢?“九章”的论文对此没有给出具体的数据,但是不难对有效分布的上限作出估算。根据经典概率理论中弱大数定理,实验装置对有效样本数的采集过程,就是逐渐逼近矩阵Tor的值的过程,可以设置一个最小有效样本数要求(等效为一个近似误差门限),例如 10000。因此对于光子数为X的Y次釆样数,有效分布不可能多于Y/10000。

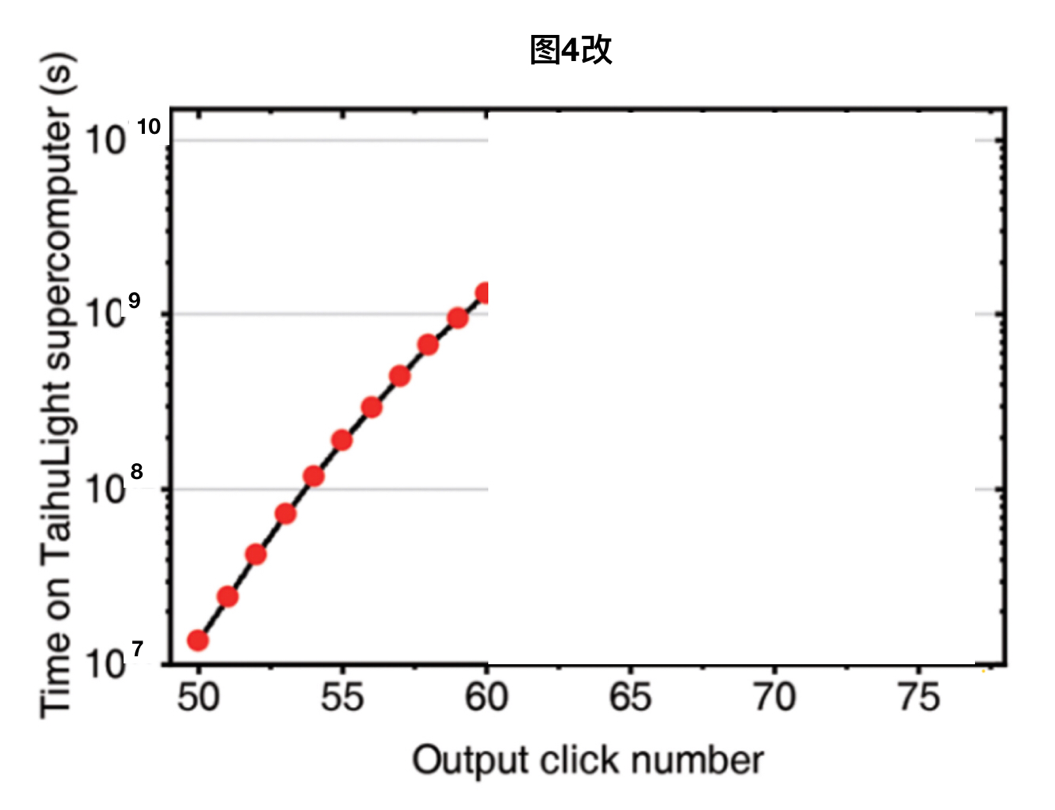

把X个光子的釆样总数改成有效分布数,并去除所有无效样本(光子总数大于60后的釆总数一共只有10000左右,无论何种分布都不可能有足够的样本),得到图4改。对图4改的曲线求积,超算总开销不可能超过4x10^9秒。

那么“九章”得到同样的结果一共又要多少时间呢?众所周知,计算总开销应该包括数据输入输出时间和计算时间的总和。“九章”论文中把采样的200秒等效于计算总开销,这只有二种解释:1)“九章”数据输入时间极短,相对于200秒可以忽略不计;2)“九章”根本就没有数据输入过程。但是第一种解释违反客观事实,对于“九章”实验装置,100维矩阵参数输入就是对九章复杂光路的置定、微调和核对,这些都是非常化时间的,输入时间远超200秒怎能忽略不计。剩下只有第二种解释,对此“九章”团队是打死也不肯承认的,因为这证实了“九章”不是通常意义上的计算机[1]。

为了摆脱在计算输入问题上的两难困境,我为“九章”团队作出如下辩解:“九章”理论上是可以通过调整实验设备参数作为数据输入的手段,虽然实际上会非常困难。数据输入困难一直就是量子计算机的软肋,只是“九章”的情况更为严重更为突出。

对于“九章”这样的实验装置,矩阵参数的输入对应的就是对光路上50个干涉仪,300个分朿器和75个反光镜的置定、微调和反复的测试,这个过程究竟要化多少时间实在很难确定,但是对于“九章”实验数据输入时间的下限值应该可以作出合理判断,估计不会低于5整天(约为4x10^5秒)。

超算总时数4x10^9 / 九章实验总时间(4x10^5+200)约等于10^4,因此“九章”比超级计算机最多也只快一万倍。但“九章”论文宣称快一百万亿倍,足足夸大了一百亿倍,想当年,亩产万斤粮也只不过夸大了几十倍,中科大“九章”团队这次真的是创下了浮夸的历史纪录!

事实上,九章”比超算快一万倍的结论也是完全站不住脚的,问题出在关于速度比较的定义上。九章与超算比速度,比的应该是求取光子在100个出口处的某种分布概率的快慢。当100维矩阵的参数确定下来,光子在100个出口的分布作为自变量给定后,计算机通过求解Tor函数值就可以精确得到该分布出现的概率;九章则通过200秒釆样,然后得到对应该种分布的样本数,原则上也可以得近似的统计概率。把这两者所化时间作比较才是客观公正的。

但是九章论文偏不这样计算,他们认为九章在采样过程中同时还得到了一些其它分布的样本数,从而可以得到额外分布的概率。九章企图把釆样实验得到的付产品来个废物利用,要求计算机也得照样一个个全都算一遍。这好像狂轰滥炸与定点清除比速度,比较的应该是两者清除既定目标所化的时间长短,但狂轰滥炸派把被自己误炸乱炸的后果也当作成绩来计算,要求定点清除也照样来上一遍,并把这些时间累加后再作比较,九章团队实在太不讲武德了。

“九章”真要能击败经典计算机取得所谓的“量子优势”,最起码要能获得某种有效的光子输出分布,即对应这种分布至少要取得上万个相同的样本。从图3C可知,符合这个要求的只可能发生在光子数30~60之间,而从图S28又可看出,光子数小于50时,计算机对100维矩阵的Tor值求解时间小于“九章”釆样所需的时间。因此“九章”如果要获得“量子优势”的话,应该发生在光子数介于50~60这个狭窄区间中。

但是必须注意,虽然在这个区间有较大的样本数,但是光子在100个出口处的分布种类更多,更是千变万化的。例如,50个出口处检测到有光子,可以是出口1~50检测到有光子,但也可以是从出口2~51处检测到光子。这两个样本虽然检测到的光子数都是50,但它们却代表了光子在100个出口处的完全不同的两种分布,它们对应的是Tor函数的两个不相同的自变量,它们的概率是不相同的。

在100个出口处总共检测到50个光子能有多少种分布呢?这是高中数学中的组合问题,答案是 C(100,50)= 100x99x98....x52x51/50!。这是一个大得非常恐怖的天文数字。虽然九章每次实验得到50个光子共有一百万次,但是这50个光子在100个出口处的不同分布的总数要远远大于一百万这个数字。这意味着,对于每种特定的分布,例如,出口处一个隔一个这种分布,很可能在整个实验过程中一次也没有釆集到,即使某些分布被检测到,但是釆样得到的样本数少得可怜,它们不具有统计意义。因此在光子数介于50~60这个区间中釆集到一万个样本的有效分布的可能性几乎为零。

归根结底,当出口处足够多时(对应于矩阵维数足够大时),取得一个有效分布是一个小概率事件,九章”实验的5千万次釆样是远远不足以获得有统计意义的结果的[2]。因此,“九章”对经典计算机取得“量子优势”是没有科学根据的,这也是国际上许多量子计算专家的共识[3]。

“九章”实验中釆集到的最多光子数是76个光子,而这样的事件却只测到了一次,这又能说明什么问题呢?难道76个光子的分布概率是5千万分之一吗?这好比你买了十次彩票中了一次大奖,难道可以判定大奖的概率是十分之一吗?76个光子事件只能说明“九章”实验的缺陷和局限性,这种样本没有统计意义纯属垃圾数据,但是在“九章”铺天盖地的宣传文章中,却把76个光子事件吹嘘成了世界纪录,这有点像一个足球运动员把球踢进了自家球门,竟然把这当成战绩到处宣扬,实在令人啼笑皆非。

另外必须强调,忽略计算的正确性和精度的情况下,单纯比较计算速度没有任何意义。“九章”论文中在估计超级计算机求解矩阵Tor值,使用的软件的字长为256bit,对应这样的计算精度,“九章”究竟需要多大的样本数才能与之相配,对此论文也缺失认真的分析和讨论。

这让我想起一个笑话:张三去求职,面试官李四问他有什么特长。他说我算术算得特别快。李四就问他,12345乘以67890等于多少?张三说,等于987654321。李四很诧异,这个答案不对啊?张三回答说,别说对不对了,你就说我算得快不快吧?

“九章”量子计算机宣称比超级电子计算机快一百万亿倍是毫无科学依据的,即使完全按照中科大“九章”团队自定义的奇葩的比赛规则,他们把战绩至少也夸大了一百亿倍!事实上,“九章”的实验数据不仅无法证明对超级电子计算机取得了量子优势,恰恰相反,“九章”实验的真正意义是证明用玻色釆样获取量子优势的路子可能走不通。为什么这条路走不通?欲知详情 且看下文分解。

参考文献

[2] “For real-world data, the result of the Torontonian function is a very small decimal, which results in a high-precision requirement. For instance, when N is 45, the result is 1.44 × 10^-25.”

您不去科学网发文是对的,真受不了那里慢吞吞的文字审查。